Hassan est un scientifique des données et a obtenu son Master of Science en Data Science de l’Université Heriot-Watt.

Introduction aux pipelines de données dans le Big Data

Toile

Un pipeline de données est un processus qui vous aide à stocker et à traiter des données. Il s’agit d’un élément essentiel dans toute organisation qui traite du Big Data. Cela peut sembler sans importance, mais réfléchissez-y une seconde : lorsque vous avez de grandes quantités de données, cela peut être difficile à gérer.

En effet, vous avez besoin de plus de ressources et de temps pour analyser et donner un sens à vos données. Cet article vous aidera à comprendre ce que sont les pipelines de données et comment ils fonctionnent.

Qu’est-ce qu’un pipeline de données ?

Un pipeline de données est un système qui gère le flux de données d’un système à un autre pour les traiter. Il peut également déplacer des données entre différentes bases de données ou instances de la même base de données.

Un pipeline de données est un composant essentiel de toute solution Big Data, vous permettant de charger des données dans votre système, puis de les traiter de différentes manières après leur chargement. Par exemple, si vous utilisez Hadoop pour votre solution Big Data, vous aurez besoin d’un pipeline de données pour transférer les données entre les différents composants du système.

Utilisation des pipelines de données dans la science des données et l’analyse

Toile

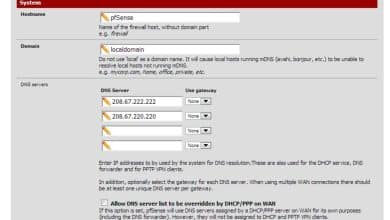

Quel est le besoin de pipelines de données ?

Les pipelines de données sont un processus piloté par les données qui permet le déplacement des données de la source à la destination. C’est un moyen d’optimiser le flux de données entre diverses applications et bases de données. Le besoin d’un pipeline de données survient lorsque vous avez plusieurs applications ou bases de données qui ont besoin d’accéder au même ensemble de données mais ne peuvent pas être connectées directement pour des raisons techniques.

Un bon cas d’utilisation serait une boutique en ligne où vous avez besoin d’informations de commande en temps réel pour le traitement, mais vous souhaitez également une copie d’archive de chaque commande à des fins comptables. Le pipeline de données peut connecter votre application et votre base de données afin que les données soient transférées de manière transparente entre elles.

Il vous permet également de filtrer et de traiter les données avant de les envoyer tout au long de leur parcours. Essentiellement, un pipeline de données est un ensemble d’outils permettant d’automatiser le déplacement des données entre diverses applications et bases de données.

Les trois types de pipelines de données

Toile

Types de pipelines de données

Le pipeline de données est un système qui connecte des sources de données à des puits de données. Il peut être utilisé pour traiter et stocker des données. Il existe trois principaux types de pipelines de données : en temps réel, par lots et dans le cloud.

1. En temps réel

Les pipelines de données en temps réel sont utilisés pour créer et exécuter des applications qui doivent réagir rapidement aux événements, tels que la détection des fraudes ou la surveillance du service client. Les pipelines en temps réel sont conçus pour une faible latence et un faible coût. Ils peuvent traiter et analyser de grandes quantités de données très rapidement. Cependant, ils ne permettent pas aux utilisateurs de stocker ou de manipuler des données de quelque manière que ce soit après qu’elles ont été traitées ou analysées par le pipeline lui-même.

2. Données de lot

Les pipelines de données par lots sont généralement utilisés dans les systèmes de veille stratégique. Ils permettent aux utilisateurs de stocker de grandes quantités de données avant de les analyser en une seule fois au lieu de traiter chaque élément individuellement au fur et à mesure qu’ils arrivent au fil du temps, comme le font les pipelines en temps réel (ce qui serait trop lent). Cela leur permet d’analyser des quantités d’informations plus importantes à la fois sans avoir autant de ressources disponibles que s’ils utilisaient à la place des méthodes de traitement en temps réel (ce qui nécessiterait plus de puissance de calcul).

3. Nuage

Les pipelines de données cloud sont le pipeline le plus récent à être développé. Ils permettent aux utilisateurs de stocker leurs données dans une base de données accessible via une interface de programmation d’application (API) au lieu d’avoir à les conserver sur leurs serveurs. Cela leur permettra d’utiliser les ressources du cloud computing sans avoir besoin d’aucun de leurs équipements. L’avantage le plus important des pipelines de données cloud est qu’ils sont beaucoup plus faciles à configurer que les pipelines traditionnels.

Les trois composants de l’architecture de pipeline de données

Toile

Architecture de pipeline de données

Les pipelines de données sont conçus pour être modulaires, ce qui signifie que vous pouvez ajouter ou supprimer des composants individuels selon vos besoins. Cela vous permet d’évoluer à mesure que votre entreprise se développe et de modifier vos processus au fil du temps pour vous adapter aux nouvelles exigences.

Les composants d’un pipeline de données peuvent inclure les éléments suivants :

- Systèmes de collecte de données : Ces systèmes collectent des données brutes à partir de diverses sources, notamment des publications sur les réseaux sociaux, des capteurs et d’autres sources de données en continu.

- Systèmes de stockage : Les systèmes de stockage de données fournissent un stockage de données brutes et traitées à long terme. Certaines solutions de stockage vous permettent d’interroger les informations stockées à l’aide de langages SQL pour exécuter des requêtes sur la base de données sans attendre la fin du traitement.

- Outils de préparation des données : Ces outils nettoient et organisent vos données brutes dans des formats qui facilitent leur analyse ultérieure dans le processus (par exemple, en supprimant les entrées en double ou en convertissant des valeurs d’un type à un autre).

Les trois principaux types de données dans les pipelines de données

Toile

Types de données

Les pipelines de données permettent aux entreprises de rassembler leurs données disparates et de les utiliser. Comme vous vous en doutez, de nombreux types de données peuvent être utilisés dans un pipeline. Voici quelques exemples:

- Données structurées : Il s’agit de votre tableur ou base de données typique. Il est généralement plus facile à utiliser avec les pipelines de données car il est déjà organisé pour vous. Par conséquent, vous n’avez pas besoin de beaucoup de travail pour le mettre sous une forme valable pour l’analyse.

- Données non structurées : Les données non structurées font référence aux images, aux fichiers audio ou aux fichiers vidéo. Bien qu’elles ne soient pas aussi faciles à utiliser que les données structurées, elles fournissent des informations intéressantes sur leur droit, en particulier lorsqu’elles sont associées à d’autres types d’ensembles de données.

- Données semi-structurées : Les données semi-structurées se situent quelque part entre structurées et non structurées. C’est comme une feuille de calcul; il comporte des lignes et des colonnes, mais il n’est pas aussi organisé qu’une base de données.

Pipeline de données et pipeline ETL : quelle est la différence ?

Toile

Pipeline de données vs pipeline ETL

Les pipelines de données sont utilisés pour concevoir et mettre en œuvre un cadre permettant de déplacer des données d’un endroit à un autre. Les pipelines ETL (extraction, transformation et chargement) sont un sous-ensemble de pipelines de données qui se concentrent sur l’extraction de données à partir de différentes sources, leur transformation dans un format adapté à l’analyse et leur chargement dans une base de données pour interrogation.

Les organisations utilisent des pipelines ETL pour extraire des données de diverses sources (comme des bases de données ou des sites Web) et les charger dans une base de données d’analyse où les analystes peuvent les interroger. Ils sont également utilisés pour effectuer des transformations sur les données afin qu’elles soient plus faciles à analyser.

L’objectif d’ETL est de garantir que tous vos systèmes communiquent de manière transparente afin que vos analystes puissent gagner du temps en nettoyant les données désordonnées avant de les utiliser.

Utilisations du pipeline de données dans la science des données et l’analyse

Toile

Cas d’utilisation

Les pipelines de données peuvent être utilisés de différentes manières. Voici quelques exemples:

- L’analyse exploratoire des données: Les pipelines de données peuvent être utilisés pour explorer de grands ensembles de données, ce qui est souvent la première étape du processus scientifique. Tout d’abord, les points de données sont analysés et organisés en groupes. Ensuite, ces groupes sont analysés plus en détail et comparés aux autres jusqu’à ce que vous disposiez de suffisamment d’informations pour conclure.

- Apprentissage automatique : Les pipelines de données peuvent également être utilisés pour l’apprentissage automatique, ce qui nécessite de saisir des données dans des modèles qui en tirent des enseignements au fil du temps. C’est ainsi que les ordinateurs apprennent à reconnaître les images ou le langage, par exemple. Les scientifiques des données utilisent ces modèles pour prédire les événements futurs en fonction des événements passés (par exemple, prédire les modèles météorologiques en fonction des conditions météorologiques actuelles).

Conclusion

Le pipeline de données est un concept qui permet de traiter de grandes quantités d’informations en temps réel. Il s’agit d’un élément essentiel de l’écosystème global du Big Data et il peut être utilisé de plusieurs façons.

Les pipelines de données ne sont pas seulement un outil utilisé par les entreprises ; ils sont également devenus une caractéristique de la communauté open source. De nombreux types de pipelines de données sont disponibles aujourd’hui, notamment Apache Spark, Apache Flink et Apache Apex. J’espère que cet article vous a aidé à mieux comprendre les pipelines de données et pourquoi ils sont essentiels.

Ce contenu est exact et fidèle au meilleur de la connaissance de l’auteur et ne vise pas à remplacer les conseils formels et individualisés d’un professionnel qualifié.

© 2022 Hassan