Ashley Doyle vient du Canada et écrit fréquemment des articles sur les ordinateurs et la technologie.

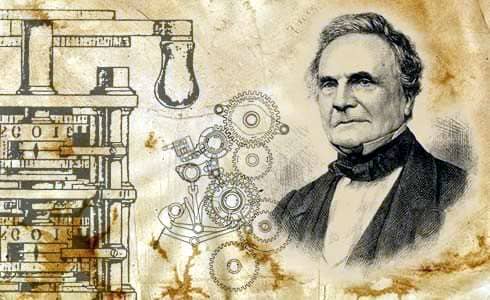

Charles Babbage

Les ordinateurs sont sans doute l’une des inventions les plus importantes de l’histoire humaine et leur développement, bien que rapide au cours du siècle dernier, s’étend sur près d’un demi-millénaire. Leur histoire riche en histoire est également un excellent exemple de la façon dont les scientifiques, les inventeurs et les mathématiciens peuvent s’appuyer sur le travail de leurs prédécesseurs pour répondre aux besoins de leur époque respective et secouer le monde avec leurs créations.

La première calculatrice

Alors que le boulier est la première calculatrice au monde, la première calculatrice mécanique a été créée en 1642. Le polymathe français Blaise Pascal a créé une machine avec une série de rouages imbriqués qui pouvaient additionner et soustraire des nombres décimaux pour aider son père, un collecteur d’impôts, à faire des sommes. . Ce premier pas vers l’ordinateur moderne en a inspiré plusieurs autres, dont le mathématicien allemand Gottfried Leibniz. À la fin du 17e siècle, il a continué à élever la conception pour remplir plus de fonctions, y compris la division et la multiplication.

Il est également crédité d’avoir été le pionnier du premier magasin ou registre de mémoire, ainsi que d’avoir inventé le code binaire. C’était une façon de représenter n’importe quel nombre décimal en utilisant seulement deux chiffres, zéro et un. Bien que ses inventions n’aient pas utilisé cette dernière, elle a inspiré le mathématicien britannique George Boole à créer une algèbre binaire ou booléenne. Cela deviendrait largement utilisé dans la conception et le fonctionnement des ordinateurs, mais ne se produirait pas avant un autre siècle.

Charles Babbage

Basé sur un concept de l’ingénieur de l’armée de Hesse JH Müller, Charles Babbage a été le premier à concevoir une calculatrice mécanique automatique pour tabuler des fonctions polynomiales. Le Difference Engine, comme on l’appelait, n’a jamais été achevé, même avec un financement initial du gouvernement britannique. Avec l’aide d’Agusta Ada Byron, qui a aidé à affiner ses idées de programmation, Babbage est allé plus loin en proposant un ordinateur général mécanique polyvalent appelé moteur analytique.

Cette machine est la première conception d’un ordinateur similaire à ce que nous voyons aujourd’hui. Il fonctionnerait sur des nombres à 40 chiffres, avec le « moulin », un ancien processeur, avec deux accumulateurs principaux et quelques auxiliaires, tandis que le magasin, ou la mémoire, aurait contenu un millier de nombres à 50 chiffres. Il y aurait plusieurs lecteurs de cartes pour interpréter les programmes et les données stockées sur les cartes perforées. Ces cartes étaient enchaînées et avec le mouvement de ces chaînes réversibles. La machine aurait effectué des sauts conditionnels et aurait permis une forme de micro-codage. Propulsé par une machine à vapeur, on pensait qu’il était capable d’additionner en quelques secondes et de multiplier ou de diviser en quelques minutes.

Le dilemme du recensement

Aux États-Unis, un recensement est effectué tous les dix ans, mais en 1880, la population avait tellement augmenté que le processus a pris huit ans pour terminer le travail à la main à l’aide de feuilles de journal. Craignant un arriéré d’estimations selon lesquelles le prochain recensement pourrait prendre une décennie entière ou plus, un concours a été organisé pour trouver une meilleure méthode.

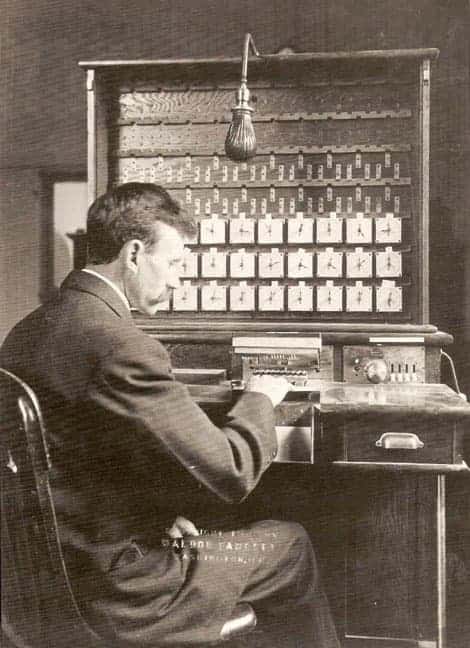

Herman Hollerith

Herman Hollerith, employé du service de recensement, a fourni la solution en créant sa première machine à tabuler. L’invention enregistrait des données sur un support qui pouvait ensuite être lu. Les supports antérieurs lisibles par machine, tels qu’un rouleau de piano, avaient été utilisés pour le contrôle, pas pour les données. Au lieu d’utiliser du ruban adhésif, il est allé avec des cartes perforées et des relais mécaniques pour incrémenter les compteurs mécaniques. Même avec la plus grande population, le recensement de 1890 a été réduit à six ans et aurait permis au gouvernement d’économiser 5 000 000 $.

Fort de ce succès, Hollerith a créé la Tabulating Machine Company, qui allait devenir International Business Machines, ou IBM. Plusieurs grands bureaux de recensement dans le monde et de grandes compagnies d’assurance ont loué ses machines et son équipement et ont acheté ses cartes, finançant le développement futur, y compris un plugboard qui pourrait être recâblé pour différentes applications.

Développement informatique en guerre

La Seconde Guerre mondiale a généré certains des ordinateurs les plus massifs et les plus puissants jamais vus à cette époque, avec des progrès accélérés par les factions opposées. Konrad Zuse d’Allemagne a fait les premiers pas en 1938, construisant le premier ordinateur binaire programmable au monde, appelé Z1, dans la maison de ses parents. L’année suivante, le physicien américain John Atanasoff et l’ingénieur électricien Clifford Berry ont construit une machine binaire plus élaborée qu’ils nomment Atanasoff Berry Computer (ABC). Ce furent les premiers à utiliser des interrupteurs électriques pour stocker les numéros. Des centaines ou des milliers de commutateurs pouvaient stocker de nombreux chiffres binaires, contrairement à leurs prédécesseurs analogiques qui stockaient des nombres en utilisant les positions des roues et des tiges.

Faites défiler pour continuer

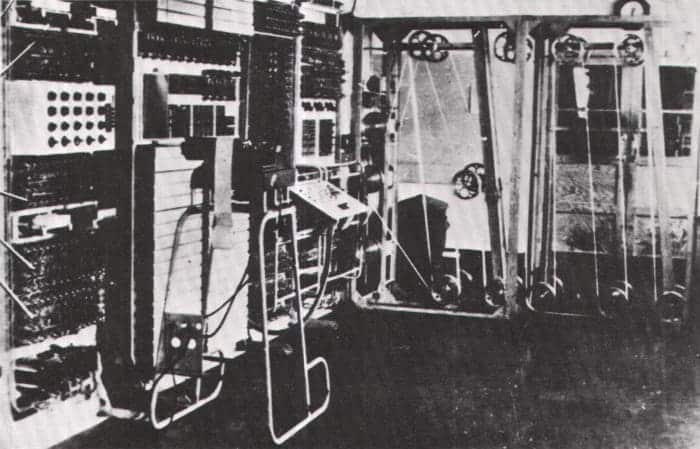

Colosse

Basée à Bletchley Park près de Londres, une équipe de mathématiciens, dont Alan Turning, a cherché une solution permettant aux forces de l’Alliance de déchiffrer les codes secrets en constante évolution des Allemands. Ils ont créé un ordinateur appelé Colossus, qui était le premier ordinateur entièrement électronique. Au lieu de relais, il utilisait une meilleure forme d’interrupteur connue sous le nom de tube à vide, qui avait été précédemment créée par Lee De Forest en 1906. Les cuves à vide, connues sous le nom d’Audion, étaient à peu près aussi grosses que le pouce d’une personne et brillaient d’un rouge ardent comme une petite ampoule électrique.

Cependant, comme il s’agissait d’un programme top secret, le premier ordinateur visible l’utilisant a été créé en 1946 par John Mauchly et J. Presper Eckert. L’ENIAC, ou Electronic Numerical Integrator And Calculator, contenait 18 000 tubes à vide, neuf fois plus que Colossus, mesurait environ quatre-vingts pieds de long et pesait 30 tonnes. Cela le rendait plus performant que son prédécesseur, qui était conçu exclusivement pour le déchiffrage de code, mais ils étaient toujours massifs, coûteux et, parfois, peu fiables.

Amplificateur de deuxième génération

Solution microélectronique

Une solution a été fournie par trois physiciens travaillant au développement d’une nouvelle technologie pour le système téléphonique public américain. John Bardeen, Walter Brattain et William Shockley de Bell Telephone Laboratories pensaient que les semi-conducteurs pouvaient être utilisés comme une meilleure forme d’amplificateur que les tubes à vide. Cela a conduit à la création du transistor à point de contact, suivi du transistor à jonction.

Malgré les nombreux avantages de l’utilisation de transistors comme commutateurs, ils devaient être câblés à la main pour connecter tous les composants ensemble, ce qui était laborieux, coûteux et sujet aux erreurs. Cela a incité Jack Kirby de Texas Instruments à créer le premier circuit intégré, une collection de transistors et d’autres composants pouvant être fabriqués en une seule fois. Robert Noyce de Fairchild en Californie a développé quelque chose de similaire en même temps mais a trouvé un moyen d’inclure des connexions entre les composants dans un circuit intégré pour automatiser l’ensemble du processus.

En 1968, Robert Noyce et Gordon Moore ont quitté Fairchild pour fonder Integrated Electronics ou Intel en abrégé. Ils avaient initialement prévu de fabriquer des puces mémoire, mais à partir d’une commande de fabrication de puces pour une gamme de calculatrices de poche, les ingénieurs Fredrico Faggin et Marcian Edward Hoff ont réalisé qu’une puce universelle pouvait être conçue pour fonctionner dans toutes. À partir de là, l’ordinateur à puce unique à usage général, ou microprocesseur, a été créé.

Premier ordinateur personnel

Ordinateur personnel

En 1974, utilisant le populaire processeur Intel connu sous le nom de 8080, le premier MITIS Altair 8800 a été construit par Ed Roberts. Cet ordinateur avait un panneau avant recouvert de lumières LED rouges et d’interrupteurs à bascule et a fait fortune à Roberts. Cela a inspiré Steve Wozniak, un employé de Hewlett-Packard et membre du Homebrew Computer Club, à utiliser un microprocesseur 6502 pour construire l’Apple I. Un de ses amis, Steve Jobs, l’a convaincu de se lancer en affaires avec la machine et les deux créer Apple Computer Corporation.

Un an plus tard, IBM a lancé l’IBM Personal Computer, ou PC, utilisant son microprocesseur 8080. Ils se sont finalement tournés vers Bill Gates et sa petite entreprise, Microsoft, pour mettre au point un système d’exploitation appelé DOS, basé sur un produit acquis auprès de Seattle Computer Products. Gates a conservé les droits sur une version très similaire pour son propre usage et les a finalement vendues à d’autres fabricants d’ordinateurs, comme Compaq et Dell, qui ont commencé à fabriquer du matériel compatible IBM.

Ordinateurs personnels modernes

Ce fut le début de l’ordinateur tel que nous le connaissons aujourd’hui. Pendant près d’un demi-siècle, les grands noms de l’industrie ont continué à rivaliser et à innover, rendant leurs produits plus élégants, plus petits, plus rapides et plus puissants. Avec des innovations majeures, comme Google Glass, et des intégrations continues dans tous les secteurs de la société, il ne fait aucun doute que l’ordinateur continuera d’évoluer pendant de nombreuses années à venir.

Cet article est exact et fidèle au meilleur de la connaissance de l’auteur. Le contenu est uniquement à des fins d’information ou de divertissement et ne remplace pas un conseil personnel ou un conseil professionnel en matière commerciale, financière, juridique ou technique.